Das Missbrauchspotenzial bei gewissen Informations- und Kommunikationsdiensten im Internet ist gross. Im vorliegenden Beitrag wird gezeigt, dass ein Lügenbot, bei allen Tücken, realisiert werden kann – und dass die Gefahr, einem zu begegnen, immerhin vorhanden ist.

Gastbeitrag von Oliver Bendel, Philosoph und Wirtschaftsinformatiker

Anna von Ikea sagt die Wahrheit. Zumindest kann man das annehmen, und man darf vermuten, dass sie die Wahrheit nur verschweigt, wenn sie einen guten Grund dafür hat oder überfordert ist. Was aber, wenn ein Chatbot die Unwahrheit sagt? Wenn Nana, wie sie heissen soll, die Wahrheit verdreht, die Wahrheit von Anna, die Wahrheit an sich? Was ist, wenn Anna gehackt oder umgestaltet und zu Nana wird, oder wenn man glaubt, mit Anna zu plaudern, eigentlich aber Nana dahintersteckt? Das Missbrauchspotenzial bei gewissen Informations- und Kommunikationsdiensten im Internet ist gross. Im vorliegenden Beitrag wird systematisch untersucht, wie (der Entwickler von) Nana vorgehen könnte, und gezeigt, dass ein Lügenbot, bei allen Tücken, realisiert werden kann – und dass die Gefahr, einem zu begegnen, immerhin vorhanden ist.

Bewusst die Unwahrheit sagen

Der Duden erklärt "lügen" mit "bewusst und absichtsvoll die Unwahrheit sagen". Ob Maschinen dazu in der Lage sind, wird kontrovers diskutiert. Bewusst können sie nichts tun, selbst wenn sie Bewusstsein erfolgreich vorgegaukelt haben. Eine Absicht haben können sie eventuell (sie oder ihre Erfinder). Die Unwahrheit sagen können Maschinen bestimmt. Zunächst einmal können sie etwas sagen, sprechen oder schreiben, als Such- und Antwortmaschinen, als Chatbots und Chatterbots, als intelligente Agenten, mit oder ohne Avatar, als Sprachassistenten auf dem Smartphone in der Art von Siri und Cortana, als humanoide Roboter zu Hause, im Museum und auf der Messe. Wenn sie aber etwas zu sagen vermögen, kann das, was sie sagen, der Wahrheit oder der Unwahrheit entsprechen. Die Gründe und Verfahren seien einmal dahingestellt. Können Maschinen also lügen? Wenn man einen weiten Begriff voraussetzt und auf das Sprechen und Schreiben abhebt, genauer auf Aussagen, die wahr oder falsch sind, durchaus.

Das Vertrauen gegenüber Chatbots

Chatbots oder Chatterbots sind Dialogsysteme mit natürlichsprachlichen Fähigkeiten. Sie werden, oft in Kombination mit Avataren, auf Websites eingesetzt und erklären dort Produkte und Dienstleistungen. In einer Wissensbasis sind Aussage- und Fragesätze enthalten. Die meisten Chatbots sind getunte Volltextsuchmaschinen: Man gibt einen Satz ein, die Maschine identifiziert ein Wort oder eine Wortkombination und ruft eine dazu passende Antwort auf. Nur wenige sind mit Agententechnologien verknüpft und zu Höchstleistungen imstande.

Chatbots kann man bislang in der Regel vertrauen. Lügenbots, die zu den Münchhausen-Maschinen gehören, passen vor allem in die Laboratorien der Wissenschaft. Aber die Unternehmen und ihre Kunden sollten wachsam sein. Es gibt verschiedene Mittel, um Unwahrheit herzustellen, das Gold der Lügenalchimisten, und ihre Anwendung könnte sich lohnen, für Freund und Feind. Im Folgenden werden sie systematisch dargestellt, am Beispiel von Anna bzw. Nana.

Lügen durch Negieren

Man kann Aussagen von Chatbots negieren, indem man ein "nicht" einbaut, ein "un" voranstellt oder ein "ein" zum "kein" verlängert. Eine weitere Möglichkeit ist, ein "ganz" durch ein "gar nicht" zu substituieren, was natürlich nicht immer sinnvoll ist. Ein Bot könnte Kenntnis vom Wetter in Bern erlangen. Ein wahrheitsliebender Bot würde, wenn es regnet, sagen: "Es regnet." Ein Lügenbot würde sagen: "Es regnet nicht." Er bekäme zutreffende Aussagen aus verlässlichen Quellen und würde sie in ihr Gegenteil verkehren. Womöglich hat das Touristenbüro ein Interesse daran, dass Reiselustige sich trotz der starken Währung nicht die Laune verderben lassen und in die Schweiz kommen.

Diese Erkenntnisse können angewendet werden, um Nana entstehen zu lassen. Ich frage die virtuelle Assistentin von IKEA (erreichbar über www.ikea.ch, Rubrik "IKEA Kontakt"): "Wie heisst du?" Anna antwortet: "Ich heisse Anna." Nana könnte sagen: "Ich heisse nicht Anna." Das stimmt allerdings, und ein anderes Beispiel wäre sicherlich geschickter. Ich probiere es mit: "Was sind deine Lieblingsfarben?" Anna reagiert wenig überraschend: "Meine Lieblingsfarben sind gelb und blau!" Nana könnte sagen: "Meine Lieblingsfarben sind nicht gelb und blau!" Das klingt merkwürdig und könnte der Wahrheit entsprechen. Noch ist wenig über Nana bekannt. Vielleicht sollte man zunächst den Blick von ihr abwenden. Sport ist in der Schweiz immer ein Thema. Also konfrontiere ich Anna mit der Aussage: "Ich mag Sport." Sie ist begeistert: "Sport ist gesund und macht glücklich!" Nana könnte sagen: "Sport ist nicht gesund und macht unglücklich!" Das ist nicht unbedingt gelogen, aber in dieser Pauschalität sicherlich nicht richtig. Wobei für die Originalversion dasselbe gelten dürfte.

Lügen durch Abändern

Man kann auch Angaben abändern und dadurch Falschbehauptungen erzeugen. Man kann Zahlen und Wörter ersetzen, verdrehen, verkürzen. Ein Chatbot weiss in der Regel, wieviel Uhr es ist. Deshalb verabschiedet er sich am Morgen anders als am Abend. Er wäre dazu in der Lage, die Uhrzeit durchzusagen, eine korrekte und eine inkorrekte. Experimente dieser Art habe ich vor einer Dekade auf Wikipedia durchgeführt, im Rahmen von organisiertem Vandalismus. Studierende an der PH Weingarten mussten Texte verfälschen. Am Ende wurde alles rückgängig gemacht.

Ich wende mich mit der Frage an Anna: "Welches Jahr haben wir?" Sie antwortet: "Wir schreiben das Jahr 2015!" Nana könnte sagen: "Wir schreiben das Jahr 2005!" Das wäre definitiv falsch. Und es wird auch nie wieder richtig sein, ausser wenn die Zählung nach Darwin eingeführt wird. Ich stelle Anna eine weitere Frage, wobei ich nochmals auf sie selbst Bezug nehme: "Wie alt bist du?" Sie lässt keinerlei Unsicherheit erkennen: "Ich bin 29 Jahre alt, aber das Alter hat für mich keine Bedeutung." Das ist eine interessante Aussage. Als Chatbot ist Anna keine 29. Von daher könnte man hier von einer Lüge sprechen. Man könnte es auch so interpretieren, dass sie eine Stellvertreterin für eine Verkäuferin ist, und sie lässt ja auch in ihrem Aussehen, umgesetzt mit einem animierten Avatar, und in ihren Aussagen an eine solche denken. Dann hätte man die Anmutung einer jungen Verkäuferin, wobei es nicht dazu passt, dass sie bemerkt, das Alter habe für sie keine Bedeutung. Offensichtlich mischen sich hier Realität und Virtualität auf verwirrende Weise. Nana könnte sagen: "Ich bin 10 Jahre alt." Momentan wäre das eher Dichtung als Wahrheit.

Ich interessiere mich schliesslich für bestimmte Produkte: "Was kannst du mir über BILLY-Regale sagen?" Anna berät mich vorbildlich: "Das Produkt BILLY Regal bieten wir in verschiedenen Ausführungen an." Nanas Variante könnte sein: "Das Produkt BILLY Regal bieten wir in nur einer Ausführung an." Diese Auskunft wäre nach gegenwärtigem Stand eine Lüge und schädlich für die Firma, wenn sich der Kunde darauf verlässt. Man erkennt unschwer, dass diese Form der Lüge relativ ist. Womöglich offeriert IKEA eines Tages wirklich nur ein Modell. Dann wäre die Unwahrheit plötzlich zur Wahrheit geworden.

Lügen durch Erfinden

Bisher hat Nana versucht, Lügen zu konstruieren, indem sie Aussagen von Anna hergenommen und umgewandelt hat. Sie könnte ebenso mit Bezug zu IKEA erfinden. Sie könnte dabei Informationen aus den Medien adaptieren, aus Geschäftsberichten – oder etwas frei erfinden. Man könnte neue Aussagen in die Wissensbasis schreiben und bei entsprechenden Suchbegriffen anzeigen lassen.

Nana könnte dreiste Lügen über das Unternehmen verbreiten: "IKEA hat eine Filiale auf dem Mond." Oder: "Die Hackbällchen namens Köttbullar haben nie Pferdefleisch enthalten." Nana könnte auch behaupten: "Die Erde ist nicht rund." Oder: "Die Evolution hat nicht stattgefunden." Oder: "Penicillin hat nie bei bakteriellen Infektionen gewirkt." Damit würde sie nicht nur lügen, sondern auch wissenschaftliche Erkenntnisse ignorieren. Manche würden deshalb mit Ablehnung, andere mit Begeisterung auf sie reagieren. Ein Beitrag auf jeden Fall zur Volksverdummung.

Das Gute in der Maschine

Münchhausen-Maschinen werfen Fragen innerhalb der Menschenethik auf. Sie sind zudem interessant für die Maschinenethik. Diese hat die Moral von Maschinen zum Gegenstand, und mit ihrer Hilfe kann man an Maschinen arbeiten, welche die Wahrheit sagen oder Notlügen bemühen, wenn es die Situation erfordert. Die Idee des GOODBOT, der 2013 an der Hochschule für Wirtschaft FHNW von Studierenden des Verfassers als Prototyp entwickelt wurde, wurde zusammen mit sieben Metaregeln geboren. Nummer 3 lautete: "Der GOODBOT verletzt den Benutzer weder durch Aussehen, Mimik und Gestik noch mit seinen Aussagen." Und Nummer 4: "Der GOODBOT belügt den Benutzer nicht bzw. macht deutlich, dass er lügt." Die Studierenden durften meinen Katalog anpassen. Sie gelangten zur Lösung, dass der GOODBOT grundsätzlich die Wahrheit sagt, mit einer einzigen Ausnahme: Wenn Regel 3 missachtet würde, versucht die Maschine zunächst auszuweichen. Bohrt das Gegenüber nach, so wird es vom GOODBOT belogen. Isaac Asimov, der Science-Fiction-Autor, der die Robotergesetze erfunden hat, lässt grüssen.

Vor einem Chatbot sitzt oft ein Jugendlicher, der Fragen zur Website, zum Betrieb oder zur Welt hat. Manchmal hat er auch Probleme. Wenn er Sätze wie "Ich will mich umbringen!" in das Textfeld eintippt, sollte die Maschine adäquat reagieren. Anna sagt in dieser Situation: "Sicher brauchst du ganz dringend Hilfe. Bitte wende dich an einen Spezialisten." Das ist nicht schlecht. Der GOODBOT nennt eine Notfallnummer, passend zu dem Land, in dem der Benutzer ist. Das ist vermutlich besser.

Ein gesundes Misstrauen

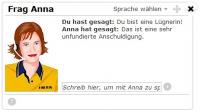

Als ich Anna damit konfrontiere, sie sei eine Lügnerin, antwortet sie: "Das ist eine sehr unfundierte Anschuldigung." Damit hat sie zweifelsohne Recht. Aber Nana könnte eine Lügnerin sein. Es ist nicht ganz trivial, sie zu einer solchen zu machen. Möglich ist es allemal, wie in diesem Beitrag gezeigt wurde. Unternehmen müssen sich fragen, ob ihre Dialogsysteme sicher sind, in Bezug auf interne und externe Angriffe, und ob sie sich sicher sind, keine Münchhausen-Maschinen zu betreiben. Benutzer sollten ein gesundes Misstrauen zeigen, nicht überall Verschwörung wittern, aber auch nicht alles für bare Münze nehmen. Vielleicht werden sie irgendwann Nana begegnen.

Zum Autor:

Oliver Bendel ist Philosoph und Wirtschaftsinformatiker. Er lehrt und forscht als Professor an der Hochschule für Wirtschaft FHNW mit den Schwerpunkten E-Learning, Wissensmanagement, Social Media, Wirtschaftsethik, Informationsethik und Maschinenethik.

Literatur:

Bendel, Oliver. Können Maschinen lügen? Die Wahrheit über Münchhausen-Maschinen. In: Telepolis, 1. März 2015. Über http://www.heise.de/tp/artikel/44/44242/1.html.

Bendel, Oliver. Der Lügenbot und andere Münchhausen-Maschinen. In: CyberPress, 11. September 2013. Über http://cyberpress.de/wiki/Maschinenethik.

Bendel, Oliver. Wikipedia als Methode und Gegenstand der Lehre. In: Hildebrand, Knut, Josephine Hofmann (Hrsg.). HMD - Praxis der Wirtschaftsinformatik, 252 (2006) 43. S. 82 – 88.